Как при помощи фотографии рассказать историю: 8 полезных советов

10 апреля 2021Фото

Вместе с Canon рассказываем, как найти цепляющий сюжет для фотографии и сделать кадр, который все запомнят.

Поделиться

0Подготовьтесь

Чутьё на сюжеты приходит с опытом. Если его пока нет, тренируйте насмотренность, изучая работы других фотографов. Это могут быть именитые профессионалы: репортажные фотографы — Юрий Козырев, Алекс Уэбб; портретисты — Стив МакКарри, Энни Лейбовиц, Марио Тестино; уличные фотографы — Эрик Ким, Мацей Дакович. Или менее известные авторы из Instagram*, чьи работы кажутся вам особенно интересными. Копировать чужие снимки не стоит, но можно поискать в них вдохновение и найти идеи для крутых ракурсов или сюжетов.</p>

Если вы собираетесь делать фотографии в известном месте, например на Красной площади в Москве или Марсовом поле в Париже, поищите его фотографии в Сети. Так вы сможете избежать повторений и сделать более нестандартные снимки.

Перед фотоохотой можно занести идеи будущих кадров в блокнот. Описывать их подробно не стоит, просто подумайте, что вы хотите запечатлеть и какие планы для этого нужно использовать.

Обращайте внимание на детали

Изображение: pernsanitfoto / ShutterstockЧтобы зрителю хотелось рассматривать кадр, нужно добавить в него жизни и загадки. Если вы фотографируете на улице, осмотритесь и найдите в толпе интересных людей. Они могут выделяться оригинальным внешним видом или находиться в необычной ситуации, например спать на скамейке.

Если речь идёт о портретном фото, приглядитесь к герою и найдите деталь в облике, которая поможет рассказать его историю. Это могут быть внешние особенности, например выразительные глаза (вспомните фотографиюThe Afghan Girl: Steve McCurry’s Enduring Portrait of Sharbat Gula «Афганской девочки», сделанную фотожурналистом Стивом МакКарри для National Geographic), или предметы, которые ему дороги или необходимы (удочка или снасти, если речь о заядлом рыбаке). На деталях можно устроить основной акцент или же сделать их частью большого сюжета.

На деталях можно устроить основной акцент или же сделать их частью большого сюжета.

Правильно подобранные детали помогут рассказать историю, даже если вы снимаете натюрморт. Соберите в кадре элементы, которые создадут общий сюжет и не будут конфликтовать друг с другом. Например, положите рядом портфель, открытки из городов мира, фотокамеру и авиабилет — и вот перед вами визуальная история о путешественнике без человека в кадре.

Делать крутые кадры с историей легко с камерой Canon EOS M200. Благодаря широкой линейке сменных объективов вы сможете удивить всех качественной макросъёмкой или захватывающей дух широкоформатной фотографией. Функции автофокусировки и ручной фокусировки помогут выделить важные детали.

Специально для начинающих фотографов в Canon EOS M200 есть функция «Творческий помощник»: она подскажет, какие настройки выбрать для конкретного кадра. Снимок можно обработать прямо в камере с помощью готовых пресетов. В настройках камеры есть сюжетные программы (портрет, пейзаж или крупный план) и творческие фильтры («Рыбий глаз», «Акварель», чёрно-белый кадр). Чтобы отправить готовое фото на смартфон или ноутбук, не нужны провода: камеру к другим устройствам можно подключить через Bluetooth или Wi-Fi.

Чтобы отправить готовое фото на смартфон или ноутбук, не нужны провода: камеру к другим устройствам можно подключить через Bluetooth или Wi-Fi.

Хочу рассказать историю

Контролируйте весь кадр, а не только центральный объект

Детали могут сыграть и против вас, если они находятся не к месту. Шанс вырезать нелепый, выбивающийся из композиции элемент с помощью кадрирования или фоторедактора будет не всегда.</p>

Внимательно посмотрите, что попадает в объектив. Заметите ненужное — двигайте камеру в сторону, вперёд и назад, или сместитесь сами. Ещё можно попробовать уменьшить масштаб фотографии или по возможности убрать препятствие из кадра вручную.

Делайте серию фотографий

1 / 0

Изображение: kasakphoto / Shutterstock

2 / 0

Изображение: kasakphoto / Shutterstock

3 / 0

Изображение: kasakphoto / Shutterstock

Снимите хотя бы 5–10 кадров на одном месте, используя разные планы, ракурсы, жанры и настройки камеры. Например, сделайте несколько фото улицы целиком, затем пару снимков конкретного человека, потом заметные детали — допустим, переполненный бумагами портфель или наспех застёгнутый пиджак.

Например, сделайте несколько фото улицы целиком, затем пару снимков конкретного человека, потом заметные детали — допустим, переполненный бумагами портфель или наспех застёгнутый пиджак.

Из получившегося набора фотографий можно выбрать самую говорящую или использовать их все вместе, сделав коллаж или галерею.

Фиксируйте эмоции

Изображение: De Visu / ShutterstockХороший кадр должен заставлять зрителя сопереживать герою снимка, независимо от того, что на нём изображено: человек, животное или предмет. Кадр должен вызвать эмоцию: позитивную или негативную. Для этого нужно эту самую эмоцию зафиксировать.

Иногда поймать её легко (к примеру, на репортажных фотографиях с места событий), иногда сложно (при портретной съёмке). Во втором случае нужно наладить контакт с героем и помочь ему расслабиться. Проведите немного времени вместе и поболтайте о чём-нибудь. Когда заметите, что человек перестал стесняться и чувствует себя комфортно, приступайте к съёмкам.

Чтобы снять эмоциональный пейзаж, понаблюдайте за местом съёмки. Подумайте, какие чувства оно у вас вызывает, и постарайтесь поймать их в объектив. Здесь снова помогут детали: сломанное дерево, цветок, животное или насекомое.

Подумайте, какие чувства оно у вас вызывает, и постарайтесь поймать их в объектив. Здесь снова помогут детали: сломанное дерево, цветок, животное или насекомое.

Следите за композицией и светом

Изображение: Punnawit Suwattananun / ShutterstockКрасиво падающая тень и правильное размещение акцентов в кадре помогут сделать хороший кадр. А ещё при их помощи также можно внести в снимок сюжет. Если вы хотите привлечь внимание к конкретной детали фотографии:

- Используйте правило третей. Мысленно поделите снимок двумя вертикальными и двумя горизонтальными линиями — получатся четыре точки пересечения. Разместите центральный элемент снимка в одной из них.

- Найдите рамки или указатели. Например, мост, арка, кроны деревьев, аллея, дверной проём. С их помощью можно выделить нужный объект на фото и, наоборот, скрыть что-то, создав загадку.

- Создайте глубину. Разместите детали на переднем, среднем и заднем плане.

Тогда картинка будет восприниматься более объёмно.

Тогда картинка будет восприниматься более объёмно.

На глубину может повлиять и свет: для этого разместите его источник позади объекта съёмки. Вот ещё несколько способов, как использовать свет и тень для сторителлинга:

- Поставьте источник света сбоку. Это поможет сделать главного героя кадра неплоским, добавит ему теней и подчеркнёт детали.

- Используйте шторы, тюль или другие преграды для света. Однотонные шторы смягчат резкий солнечный свет. Если на них есть прорези или текстура (например, кружевной тюль) — добавят тени форму.

- Сделайте свет цветным. Возьмите яркие воздушные шары, зонтик или другой полупрозрачный предмет и разместите его так, чтобы он закрывал солнце или другой источник света.

Не бойтесь экспериментировать

Изображение: Laurent CHEVALLIER / ShutterstockИногда для создания кадра с историей привычных ракурсов будет недостаточно. Найти выигрышный угол съёмки помогут нестандартные позы: попробуйте лечь или сесть на землю, забраться повыше на лестницу. Пример удачного необычного ракурса — фотографияBritain’s Queen Elizabeth II arrives to attend a national service of thanksgiving for the Queen’s 90th birthday at St Paul’s Cathedral in London Елизаветы II, сделанная Тоби Мелвиллом в 2019 году. Фотограф снял королеву сверху, в то время как она шла по собору Святого Павла в Лондоне. Пол здания похож на шахматную доску: получилось, что королева делает ход как одноимённая фигура в настольной игре.

Пример удачного необычного ракурса — фотографияBritain’s Queen Elizabeth II arrives to attend a national service of thanksgiving for the Queen’s 90th birthday at St Paul’s Cathedral in London Елизаветы II, сделанная Тоби Мелвиллом в 2019 году. Фотограф снял королеву сверху, в то время как она шла по собору Святого Павла в Лондоне. Пол здания похож на шахматную доску: получилось, что королева делает ход как одноимённая фигура в настольной игре.

И не стесняйтесь пользоваться камерой в окружении людей. Получить живую фотографию с историей на улице проще, чем в других условиях: посмотрите, как эффектно смотрятся работы стрит-фотографов, например Зуна ЛиInstagram* @zunleephoto или Лукаса ВашакаInstagram* @lwaszak.

Экспериментировать с Canon EOS M200 проще простого. У камеры есть оптический стабилизатор изображения, который позволяет делать чёткие кадры даже в движении. Благодаря откидному сенсорному экрану можно делать селфи или быстро снимать интересные сюжеты, которые происходят позади вас. Кроме того, камера Canon EOS M200 справится с работой в непростых погодных условиях: она выдерживает температуру до 40 градусов тепла и влажность до 85%.

Кроме того, камера Canon EOS M200 справится с работой в непростых погодных условиях: она выдерживает температуру до 40 градусов тепла и влажность до 85%.

Узнать больше

Продумайте постобработку

Изображение: OlegRi / ShutterstockНа создание истории и передачу эмоций влияет не только композиция кадра, но и его оформление. Попробуйте поиграть со снимком в фоторедакторе: меняйте контраст, теплоту, экспозицию, баланс белого. И добавьте цветовые фильтры — преобладающие оттенки помогут скорректировать общее настроение снимка. К примеру:

- красный добавляет экспрессии — силы, страсти, злости;

- оранжевый помогает передать уверенность;

- жёлтый придаёт кадру энергии и ощущения счастья;

- зелёный передаёт ощущение спокойствия и умиротворения;

- тёмно-синий передаёт грусть или даже страх.

Ещё один способ изменить настроение снимка — сделать его чёрно-белым. Такой приём поможет привлечь большее внимание к деталям, эмоциям героев и сюжету.

Такой приём поможет привлечь большее внимание к деталям, эмоциям героев и сюжету.

*Деятельность Meta Platforms Inc. и принадлежащих ей социальных сетей Facebook и Instagram запрещена на территории РФ.

Ищем сюжет для документальной фотографии

Что такое документальная фотография? Когда-то, лет 30-40 назад, под этим термином подразумевалась фотокарточка 6х7 см. для паспорта или 3х4 см. на пропуск для того, чтобы проходить на фабрику или на завод. Некоторые и сейчас так считают. Но это неправильно. Документальная фотография — это фотография, ставшая документом. То есть такой снимок, который показывает зрителю один из моментов какого-либо важного события, рассказывает какую-нибудь историю. Эта история или это событие могут быть и трагическими, и трогательными, и смешными… Главная задача фотографа-документалиста – выхватить из происходящего перед его объективом самое важное, самое значимое. И показать это зрителю. Причем так показать, чтобы у зрителя появились те или иные эмоции. Чтобы зритель улыбнулся, чтобы стал переживать… А возможно, ему даже станет страшно от того, что он увидит на снимке. Короче, документальная фотография — это отражение реальной жизни. Всего того, что происходит вокруг нас. Те снимки, которые публикуются на страницах газет, на новостных сайтах в интернете, те фотографии, которые оседают в архивах.

Чтобы зритель улыбнулся, чтобы стал переживать… А возможно, ему даже станет страшно от того, что он увидит на снимке. Короче, документальная фотография — это отражение реальной жизни. Всего того, что происходит вокруг нас. Те снимки, которые публикуются на страницах газет, на новостных сайтах в интернете, те фотографии, которые оседают в архивах.

Основная задача документальной фотографии – не только проинформировать человека о каком-то событии, но и заставить задуматься о своей собственной жизни, о жизни других людей, живущих рядом, а, возможно, даже и сделать что-то, чтобы изменить окружающий нас мир, сделать его чище, лучше, уютнее.

Попробовать свои собственные силы в фотодокументалистике может каждый, даже начинающий фотолюбитель. Даже тот, кто только вчера взял в руки фотоаппарат. Что вам мешает попробовать посредством фотографии рассказать всем-всем-всем о том, что происходит около вас: в вашей стране, в вашем городе, на вашей улице, в конце концов? Покажите другим людям то, что не видят, не замечают они.

В нашей сегодняшней статье мы постараемся дать ответы на несколько вопросов, касающихся документальной фотографии.

Что снимать? Где искать сюжеты?

Глубоко ошибается тот, кто считает, что для того чтобы сделать запоминающуюся документальную фотографию, фотографу обязательно нужно находиться на каком-то значимом мероприятии, быть в гуще событий. Ну, хотя бы на многотысячном митинге, на месте крупного пожара, на важном совещании у министра… Конечно, и в этом случае сделать хороший документальный снимок можно (кстати, далеко не каждый фотограф, оказавшийся в самом центре значимого события, сможет передать в своих снимках весь их драматизм, весь накал страстей). Но гораздо сложнее, а поэтому и интереснее искать сюжеты для документальной фотографии где-то в другом месте. Просто на городских улицах, например. Или за городом, в заброшенной деревне.

Должна ли документальная фотография быть художественной?

Конечно же, должна! И документальная фотография, точно так же как и видовая (пейзаж, например), как портрет и как натюрморт должна быть произведением искусства. Ну, по крайней мере, к этому нужно хотя бы стремиться. Почему зритель обращает внимание на документальный снимок? Только ли потому, что фотограф запечатлел на нем какой-то интересный момент? Конечно, момент важен. Но важен не только момент. То есть, не только то, что показано на фотографии, но и то, как это показано. Цвет, свет, композиция — про всё это нельзя забывать и в фотодокументалистике. Всё это помогает фотографу донести до зрителя самое важное: эмоциональную составляющую происходящего, еще острее обратить внимание зрителя на те или иные детали и моменты.

Хоть раз вы обращали внимание на то, что достаточно часто документальные фотографии бывают не цветными, а черно-белыми? Как вы думаете, почему? Ответ тут очень прост. Потому, что отсутствие цвета акцентирует внимание зрителя на том самом важном, что хотел донести до него автор снимка. Цвет отвлекает. А черно-белое изображение концентрирует внимание, еще сильнее подчеркивает драматизм события, показанного на снимке.

Иногда для концентрирования внимания зрителя на самом важном, некоторые фотографы в процессе постобработки снимка на компьютере в графических редакторах, применяют эффект виньетирования. Этот прием придает изображению некоторую остроту.

Большое значение в документальной фотографии, точно так же как и в других видах этого искусства, имеет точка съемки и ракурс. Если точка съемки фотографом выбрана правильно, то снимок может стать намного более эффектным и эмоциональным, чем нежели он был бы сделан с обычной точки, с уровня глаз снимающего. Не стесняйтесь, снимайте сверху, снизу, под неожиданным и непривычным углом. Всё это усилит эмоциональность вашего снимка.

Не стесняйтесь, снимайте сверху, снизу, под неожиданным и непривычным углом. Всё это усилит эмоциональность вашего снимка.

Как вести себя при съемке фоторепортажа?

Вести себя нужно очень и очень осторожно. Причин этому несколько. Первая – это то, что далеко не каждому человеку, имеющему шанс попасть в поле зрения вашего фотоаппарата, хочется быть сфотографированным. А во время волнительных событий реакция любого человека может быть неадекватной. С этим следует считаться. Тем более, что в этом случае и закон на его стороне. Особенно осторожным в этом плане нужно быть при съемке трагедий, стихийных бедствие, других подобных происшествий. Не переступайте в своей работе этические, моральные границы того. Умейте иногда сказать себе «нет» или «Стоп. Вот это показывать уже нельзя». Вторая причина для того, чтобы быть осторожным – это опасность пострадать самому. Упасть, провалиться куда-то и так далее. При неосторожном поведении при съемке фоторепортажа можно, например, угодить под автомобиль, на вас может упасть что-то с высоты… Третья причина – не мешайте работать коллегам и другим специалистам.

А надежным помощником вам в такого рода съемке станет хороший длиннофокусный объектив, который позволит вам снимать с достаточно удаленного расстояния и при этом никому не мешать.

Как правильно настроить фотоаппарат для документальной съемки?

Главная задача для фотографа-репортажника, для фотографа-документалиста — это зафиксировать самый важный момент происходящего события, тот момент, который уже не повторится больше никогда. И где и в какую минуту это произойдет — не знает никто. Вот поэтому фотохроникеру нужно уметь находится в постоянной «боевой готовности». То есть иметь великолепную реакцию на происходящее, умение в любую секунду нажать на спусковую кнопку фотокамеры. Но, увы, в таком случае очень часто у вас просто может не оказаться достаточно времени для того, чтобы правильно настроить фотоаппарат. Вот поэтому дадим вам такую рекомендацию: снимайте в режиме приоритета выдержки. При этом выдержка должна быть достаточно короткой, около 1/250 секунды.

Metz — каждый сюжет со счастливым финалом.

В современный камкордерах, цифровых зеркальных камерах и системных камерах всё чаще и чаще встречается режим видеосъёмки качества Full-HD. Это даёт видеографам-любителям множество новых возможностей использования их оборудования. Однако, это также подразумевает повышение требований, выставляемых к освещению. Выбирая рациональные продукты из линейки светодиодных осветительных приборов Metz mecalight, теперь вы сможете получить идеальное освещение любого сюжета.

“Беспроводной” режим.

Осветительные светодиодные приборы для видеосъёмки Metz mecalight LED-960 DL и 960 BC video оснащены встроенной беспроводной функцией. Она обеспечивает возможность настройки и регулировки яркости и/ или цветовой температуры * без проводов – от одного осветительного прибора к другому.

Можно настроить вплоть до 15 независимых каналов, благодаря чему вы получаете невероятный простор для создания креативного освещения. Если изменить параметры одного конкретного осветительного прибора, он автоматически становится передатчиком и отправляет сигнал изменения настроек на остальные осветительные приборы, которые автоматически становятся приёмниками. На практике это означает гибкость и практичность использования осветительных приборов.

Гибкое расширение.

Если вам требуется более высокая выходная мощность света, осветительный прибор для видео съёмки Metz mecalight даёт возможность гибкого расширения — а именно: приборы из одной и той же линейки можно модульно подключать друг к другу и устанавливать на крепежные рельсы, предлагаемые в качестве дополнительного, не входящего в базовый комплект аксессуара.

Гибкость установки.

Кронштейн mecalight Flex Arm FH-100 особенно хорошо подходит для использования при видео съёмке, когда требуется творческий подход к управлению освещением. FH-100 можно сгибать, что позволяет добиться оптимального положения осветительных светодиодных приборов mecalight. Он также идеально подойдёт для макросъёмки, т.к. с его помощью можно превосходно осветить объект съёмки под различными углами.

Для каждого сюжета света более чем достаточно.

Даже при слабом окружающем освещении осветительные светодиодные приборы Metz mecalight обеспечат идеальную подсветку для объекта вашей съёмки. Это также относится и к съемке, когда объект освещён сзади, съёмке внутри помещений или вечером.

С использованием mecalight Без использования mecalight

*Регулировка цветовой температуры возможна только на светодиодных осветительных приборах mecalight LED-960 BC.

mecalight LED-960 BC mecalight LED-960 DL

144 мощных светодиода с высоким индексом цветопередачи для идеального освещения в любой ситуации.

Высокая интенсивность — умная регулировка.

Высокие технологии для оптимального освещения.

Освещайте вашу съемочную площадку, как профессионалы: новые осветительные приборы mecalight для видео съёмки оснащены 144 светодиодами с плавно регулируемой яркостью и с высоким индексом цветопередачи, гарантируя лучшее освещение любого объекта съемки. Осветительный прибор mecalight LED-960 DL обеспечивает освещение мощностью до 960 лк. При необходимости осветительные приборы LED-960 могут устанавливаться модульно, повышая, таким образом, эффект освещённости в соответствии с вашими требованиями.

Осветительный прибор mecalight LED-960 BC, ( двухцветный), обеспечивает освещение мощностью до 840лк , а также даёт возможность плавной регулировки цветовой температуры для достижения наилучших результатов в зависимости от дневного или искусственного света.

Еще одно технологическое преимущество приборов серии 960 — это встроенная функция беспроводной работы, благодаря которой настройка и регулировка яркости и цветовой температуры всех осветительных приборов проходят быстро и легко.

На mecalight LED-960 BC можно плавно регулировать яркость и цветовую температуру.

*Регулировка цветовой температуры возможна только на светодиодных осветительных приборах mecalight LED-960 BC.

|

Характеристики |

mecalight LED-960 | mecalight LED-960 DL |

| Светодиодные осветительные приборы | 144 светодиода с высоким индексом цветопередачи | 144 светодиода с высоким индексом цветопередачи |

| Индекс цветопередачи | > 90 | > 90 |

| Угол падения луча | 65° | 65° |

| Подключение к электросети | да | да |

| Освещённость | 840 лк | 960 лк |

| Питание | 6 батареек / аккумуляторов размера AA / или аккумуляторы Sony NPF 6 батареек / аккумуляторов размера AA / или аккумуляторы Sony NPF | 6 батареек / аккумуляторов размера AA / или аккумуляторы Sony NPF 6 батареек / аккумуляторов размера AA / или аккумуляторы Sony NPF |

| Рабочее напряжение | 4,8 — 9,0 В | 4,8 — 9,0 В |

| Цветовая температура | 3200 — 5600 K | 5600 K |

| Рассеивающий фильтр | да | да |

| Фильтр искусственного света 3200K | да | да |

| Гнездо для штатива | А ¼” | А ¼” |

| Габариты | 140 x 96 x 55 мм | 140 x 96 x 55 мм |

| Вес | 320 г | 310 г |

| Плавная регулировка | 0 — 100 % | 0 — 100 % |

| Возможность вертикального и горизонтального поворота | да | да |

Встроенная функция беспроводной работы предусматривает около 15 каналов.

Достаточно мощности для всей съёмки: осветительные приборы питаются от батареек/ аккумуляторов размера AA, аккумуляторов Sony NPF или от электросети, как вы пожелаете.

Светодиодные осветительные приборы предназначены для освещения во время фото- или видеосъёмки. Они не подходят для использовании яв качестве бытовых осветительных приборов.

Тема: Сюжет, как основа фотографии«Сюжет есть во всем. В каждом сюжете есть ритм. В чувстве такого ритма и заключается смысл. Фотография – это фиксация такого смысла, который существует сам по себе» Андре Кертеш Раскрытие темы предполагает 3 занятия. Цель: развить навык видеть, формулировать сюжет, и передавать его при создании собственных работ. Задачи:

Участники: учащиеся 5 классов Для изучения темы используется многоканальный метод.

Урок 1Учитель: — Ребята, сегодня мы поговорим о таком важном явлении в фотографии, как сюжет. Что же это такое? Фотография это индивидуальное искусство. Фотограф через фотографии передаёт своё понимание мира природы, вещей, человека. Каждый из вас, если возьмёт фотоаппарат, по-своему увидит окружающий мир, отобразит мгновение. Например, вы увидели после дождя яркую, сочную радугу. Сколько эмоций, ощущений вы испытываете при этом! Вам хочется поделиться ими,. и у вас рождается идея запечатлеть ее в фотографии, так, чтобы передать через нее ваши эмоции. А если вы добавите в кадр немного недосказанности, то зритель, которому вы ее потом покажете, наверняка начнет фантазировать и додумывать вашу историю. Наличие сюжета является самым важным в фотографии и влияет на «интересность» фотографии. Для грамотного построения кадра не обязательно быть виртуозом, достаточно спросить себя:

Давайте обратимся к работам художников и фотографов, узнаем о чем говорит автор и постараемся рассмотреть сюжет произведения. Учитель предлагает учащимся для рассмотрения репродукции картин и фотографий. Учащиеся изучают раздаточный материал, высказываются о том, что они видят, чувствуют, как выстроен сюжет (идея) художника, и что хотел передать автор. I. Поиск сюжета. От картины до фотографии. Поиск сюжета. От картины до фотографии. Фотография многое вобрала в себя из многовекового опыта развития изобразительного искусства. В качестве иллюстрации этого учитель предлагает рассмотреть:

Мстислав Добужинский. Николай Ге. Портрет Л.Н. Толстого 1884 гФото К. Буллы. 1900-е Картина Конки. М. В. Добужинский. 1909 г . Конка у здания Фондовой биржи на стрелке Васильевского острова. Фотография К. Буллы. 1906 г. Фёдор Шаляпин поёт с листа на репетиции Улица. К. Булла в зале народного дома. Фото К. Буллы. 1913 г. Фотографии Андре Кертеша Урок 2II. Кинематограф

Учитель: -Также как книга для писателя, музыка для музыканта или картина для художника, кино для режиссёра – это способ выражения собственных мыслей, чувств и желаний. Кино выросло из фотографии. В 1895 Люмьер изобрёл киноаппарат для съёмки и проекции «движущихся фотографий», пригодный для коммерческого использования. Первые кинофильмы состояли из одного плана, редко превышавшего одну минуту по продолжительности. Это действительно были «движущиеся фотографии». Технологические истоки указывают на две принципиальные составляющие кинематографа: фотография (фиксация световых лучей) и движение (динамика визуальных образов). Фотографический принцип связывает кино с изобразительной традицией, идущей от живописи, то есть связывает кино с идеей искусства. Учитель: — Не будем останавливаться на истории кинематографа, это не наша цель. Важно другое. Кино и фотографии требуют обязательного соучастия зрителя в их восприятии. Фотография — это видение мира глазами фотографа. Точно так же происходит и в кино, которое отражает взгляд и позицию режиссера. — Для фотографа, как и для режиссера важное значение имеет сюжет.

Учитель показывает учащимся отрывки из фильма.

Предложенные учителем сцены из фильма обсуждаются с учениками с точки зрения того, как передан сюжет. III. Самостоятельная работа. Источники.К следующему занятию учащиеся знакомятся с источниками, предложенными учителем:

Также учащиеся приносят свои фотографии с видами города, близких людей, памятных событий. Урок 4. Итоговое занятие.

При обсуждении не должна выноситься оценка работ. Это не является целью обсуждения. Учащиеся должны быть предупреждены об этом. Учащиеся анализируют работы друг друга, рассматривают как и насколько удачно раскрыт сюжет на их фотографиях. Во время анализа работ, учащиеся отвечают на вопросы:

В коллективном просмотре важно акцентировать внимание на том, что увидели другие, в сравнении с тем, что хотел сказать автор.

Анализируя фотографии метров, учащиеся учатся у мастеров технике передачи сюжета. Анализируют, пересказывают свое видение того, что хотел сказать автор. Какие методы, какие способы передачи своих идей, чувств, настроений использовал фотограф.

Учитель подводит итоги работы на занятиях по данной теме. Занятия по данной теме позволили учащимся узнать, что такое сюжет и его важность в изобразительном искусстве, фотографии и в кино. Учащиеся получили навык анализа сюжета фотографий. В результате работы узнали методы и способы раскрытия сюжета, которые использовали знаменитые фотографы. В дальнейшем это поможет учащимся в совершенствовании мастерства в области фотографии. Источники:

| |||

| План: Введение Культурные традиции бурятского народа как основа здорового… При этом достижения современной официальной медицины не привели к полному вытеснению традиционной медицинской культуры и, соответственно,.  .. .. | Межрегиональный конкурс творческих проектов учащихся, студентов и… Пешком, в суровые январские морозы прабабушка прошла 160 км. Мимолетная встреча на вокзале и снова разлука. Как подросли девочки… | ||

| Положение об открытом фестивале фотографии Первый открытый фестиваль фотографии в Сергиевом Посаде (далее – Фотофестиваль) проводится в рамках празднования 12 июня государственного… | Методические рекомендации для педагогов Воспитание любви к родному краю как основа патриотического воспитания дошкольников | ||

| Обновление сайта Leites net (май 2015) Трансформаторы и электрические реакторы, Генеалогия, Разное, Фотографии, Новости, Контактная информация и очередностью 9-ти кнопок… | «Старинные танцы как жанровая основа инструментального цикла» Клавирные сюиты и партиты: соотношение традиционного и новаторского в их трактовке. 5 | ||

| Классный час в 6а классе «Книга памяти Михневской средней школы» (75летию школы посвящается) Она является одной из особо значимой экспозиции школьного музея.  Здесь данные о выпускниках школы (фотографии, письма выпускников,… Здесь данные о выпускниках школы (фотографии, письма выпускников,… | Система учебников Алгоритмы успеха Программа: «Системно-деятельностный подход при обучении химии как основа реализации стандартов нового поколения» | ||

| Проектная деятельность как основа работы с одаренными детьми Гбоу средняя школа 368 с углубленным изучением английского языка Фрунзенского района Петербурга | Методика применения игровых технологий на уроках русского языка как… Трактовка термина «технология» (в психолого – педагогической литературе) |

13 фото, сюжет которых заставляет задуматься апрель 2019 | ngs42.ru

Все новости17 погибших, 11 из них — дети: всё, что известно о нападении на школу в Ижевске

Как долго продлится частичная мобилизация? Главные новости СВО за 26 сентября

В Адыгее повестку вручили ветерану МВД на инвалидной коляске, но затем извинились

Всё, что известно о трагедии в школе в Ижевске к этому часу: видеорепортаж

Можно ли военнообязанным покидать Россию? А выезжать в другой город или регион? Разбор с экспертами

По всей России люди выстраиваются в очереди к нотариусам, чтобы оформить доверенность на близких

На границе с Казахстаном останавливают подлежащих мобилизации и вручают повестки

В закрывающейся Финляндии нашествие россиян. Некоторые идут лесами

Некоторые идут лесами

Кто будет платить алименты, если отца призвали по мобилизации? Отвечает юрист

В России объявили мобилизацию. Как узнать, попадаю ли я под призыв?

Меня мобилизовали ошибочно. Куда обращаться?

Стрельба в военкомате. Что известно про 25-летнего задержанного и в каком состоянии военком — видеоДетки из будущего: 20 красивых детских имен, которые будут популярны в 2023 году

От комиссариата до учебки: власти Кузбасса будут сопровождать мобилизованных из региона

Теплый октябрь, холодный февраль: синоптики дали прогноз погоды в Кузбассе на ближайшие полгода

В Кремле прокомментировали возможное закрытие границ

Кто резервист, а кто запасник? Объясняем различия

До -7 и с мокрым снегом: в Кузбасс пришло похолодание

Закулисье ЛДК: показываем, как готовят площадку к международному форуму в Кемерове

Дневник сибиряка, который уволился, оставил квартиру и пересек границу с Казахстаном — 15 часов из его жизни

Совладелец «Зимней вишни» останется в СИЗО еще на несколько месяцев

В ижевской школе во время стрельбы погибли дети

Все призывники по мобилизации досрочно отправятся на пенсию

К школе несут цветы, лампадки и мягкие игрушки. Всё о стрельбе в Ижевске

Всё о стрельбе в Ижевске

Будут ли призывать ограниченно годных на военные сборы и что делать категории В? Отвечают эксперты

Неизвестный устроил стрельбу в ижевской школе

«Евраз полыхает огнем»: что на самом деле случилось на металлургическом комбинате в Новокузнецке

Мобилизованным пообещали льготы на налоги и коммуналку

В Иркутской области молодой человек выстрелил в военкома

Зараженных всё меньше: публикуем последние данные по COVID-19 в Кузбассе

Двое погибли, четверо пострадали: в ГИБДД рассказали подробности жуткой аварии на трассе в Кузбассе

Минспорт сообщил, какие сотрудники нужны в «Кузбасс-Арену». Публикуем список должностей с зарплатами

Авто Без «Тойот», но с новым «Чери»: что происходит на российском авторынке

В Кузбассе из-за ДТП перекрывали участок федеральной трассы. Узнали подробности

Уходя, гасите свет: умеете ли вы экономить на коммуналке

«Страшно за своего ребенка»: отцы из Кемерова и Курска придумали устройство от выпадения детей из окон. Их история

Их история

Отсрочка для студентов и очереди к нотариусам. Главные новости СВО за 25 сентября

Какие документы и доверенности стоит оформить, если вы мобилизованы. Инструкция юриста

Там просто бесконечный поток: на границе Волгоградской области и Казахстана образовались гигантские очереди

Все новости

Поделиться

Глядя на эти фотографии, можно придумать целый сюжет для фэнтезийного фильма или книги, причем у каждого зрителя будет своя версия развития событий, только дайте волю воображению. Среди культа «фото для Instagram» подобные снимки притягивают взгляд и доставляют эстетическое удовольствие отсутствием одинаковых кадров девушек в одних и тех же позировках. Корреспондент НГС.АФИША собрала несколько интересных фотографий с сюжетом и поговорила с авторами работ — они снимают целые саги и полносюжетные истории. Ради идеального кадра им приходится долго трудиться, и порой реализовать задуманную идею кажется невозможным, но они стараются — посмотрите, что из этого выходит.

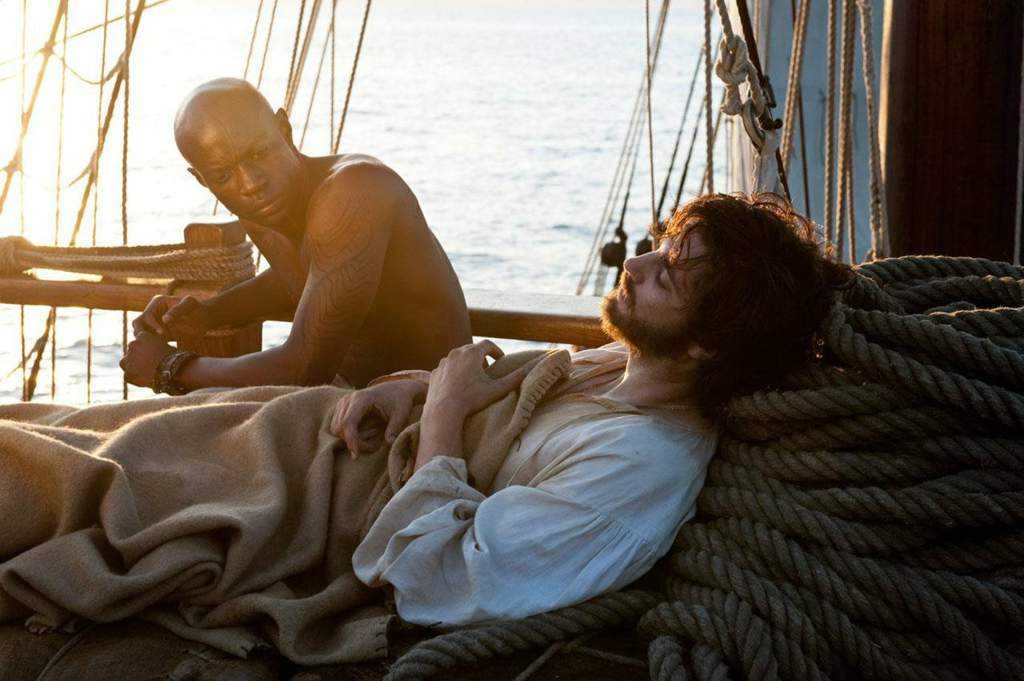

Идея снять историю любви о рыбаке и спасенной им девушке, которая тонула в море, увлекла Юлию Шипилову. Это серия была задумана в рамках воркшопа, съемку решено было провести на улице.

«Несмотря на мрачность истории, всё прошло довольно весело и позитивно. Единственное, что смущало, — было очень холодно. Осень, съемка у воды, ветрено. Тяжелее всего пришлось модели, она «тонула» несколько раз», — рассказывает Юлия. Фотографией девушка занимается уже три года.

Поделиться

Серия снимков называется «Левиафан».

Поделиться

По сюжету рыбак спас из моря девушку, они влюбились друг в друга.

Поделиться

Какое-то время жили счастливо, у них родились дети, а потом море вновь отняло у рыбака любимую.

Поделиться

С приближением выхода финального сезона сериала «Игра престолов» только ленивый не снимает девушек в образе Дейнерис Таргариен. Но сделать это максимально похоже и не вульгарно получается далеко не у всех.

Поделиться

«Многими любимая «Игра престолов» вдохновила нас на эту съёмку. Модель на роль Дейнерис нашли быстро — девочка с белыми волосами. Дальше дело за нами — взяли в прокат платье, продумали макияж и причёску. Для съемок выбрали заснеженное место на берегу Оби. Было холодно, но модель оказалась стойкая и морозоустойчивая», — рассказывает Елена Захарченко про свою недавнюю фотосессию.

Модель на роль Дейнерис нашли быстро — девочка с белыми волосами. Дальше дело за нами — взяли в прокат платье, продумали макияж и причёску. Для съемок выбрали заснеженное место на берегу Оби. Было холодно, но модель оказалась стойкая и морозоустойчивая», — рассказывает Елена Захарченко про свою недавнюю фотосессию.

Поделиться

Для антуража команда хотела взять в аренду лошадь, но в последний момент все передумали и решили, что драконы будут смотреться эффектнее. Правда, пришлось изрядно потрудиться в фотошопе.

Поделиться

У Елены есть команда, они реализуют самые разные проекты и тематические съемки.

«Этот проект называется «7 грехов». В течение месяца мы искали подходящих под каждый образ моделей, тщательно продумывали все детали и то, как интереснее преподнести каждую грешницу. Нужно было раскрыть те детали, которые бы подчеркивали образ. Для гордыни нашли корону, для обжорства — эклеры, для зависти — арендовали змею, для гнева — красные линзы и огненные волосы, алчность — деньги, похоть — роза с шипами, лень — спутанные волосы».

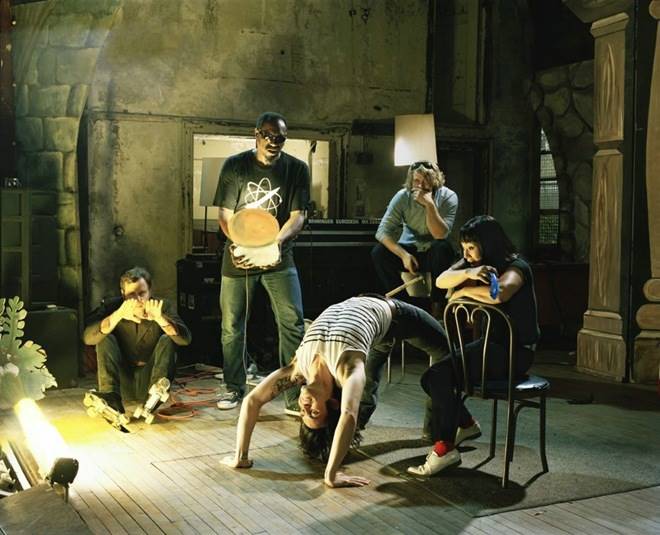

Александр работает под псевдонимом Шиша Бродский. Фотограф снимает саги, и для каждой фотосессии у него есть сценарий.

Поделиться

«В 2009 году мне в руки попал зеркальный фотоаппарат, дали на время, просто попробовать, что получится. Я сделал несколько кадров и понял, что это моё. Первые сценарии делал с друзьями, потом понемногу стали появляться новые знакомые, которые хотели принять участие в моих фотопроектах».

Поделиться

Сейчас в команде у Александра около 30 человек, они лазят по болотам, заброшенным местам, лесам, снимают самые разные сцены.

Поделиться

В прошлом году НГС уже писал о необычной съемке Бродского — с рогатыми демонами и вырванным сердцем.

Екатерину Плотникову тоже больше привлекают продуманные истории. Чаще всего девушка берет идеи для съемок из фольклора или придумывает сама.

Поделиться

Эта съёмка называется «Похищенная драконом». И изначально Екатерине казалось, что воплотить эту идею в жизнь невозможно.

«Я несколько дней бродила по строительным магазинам, высматривая подходящие материалы для хвоста. Снимали на Алтае, нужна была горная местность. На сборку хвоста у нас ушло около трех часов — собирали прям около трассы, где остановились. Самое сложное было затащить тушку дракона на гору», — делится Екатерина.

Поделиться

Эта съёмка у Екатерины проходила в Хакасии.

«На просторах интернета я наткнулась на интересное местечко с названием «Тортуга», где стоит настоящий пиратский корабль. Проехать мимо него мы не могли, поэтому вопрос со съёмкой был сразу решен, оставалось лишь сшить подходящее платье для модели и добраться до локации».

Поделиться

А здесь модель прилегла в самое настоящее болото — чего не сделаешь ради красивого кадра.

«Я давно мечтала о съемке в болоте, но найти модель, которая согласилась бы на подобную съёмку? К счастью, такие сумасшедшие есть. Болото нашли недалеко от Новосибирска. Холодное утро, рассвет, болото плохо пахло, вокруг плавали бутылки и фантики из-под кальмаров. Мы расчистили небольшой кусочек пространства, в которой предстояло окунуться модели. Это были стремительные и быстрые кадры».

Мы расчистили небольшой кусочек пространства, в которой предстояло окунуться модели. Это были стремительные и быстрые кадры».

Алёна Золотухина

Фото Юлии Шипиловой (1–4), Елены Захарченко (5–7), Шиши Бродского (8–10), Екатерины Плотниковой (11–13)

Алёна Золотухина

Журналист НГС

Апрель-2019ИсторияСибирякиСъемкаСюжетФотоФотография

- ЛАЙК0

- СМЕХ0

- УДИВЛЕНИЕ0

- ГНЕВ0

- ПЕЧАЛЬ0

Увидели опечатку? Выделите фрагмент и нажмите Ctrl+Enter

КОММЕНТАРИИ0

Добавить комментарийНовости СМИ2

Новости СМИ2

Сюжет в стрит фотографии — должен ли он быть в уличной фотографии

Продолжаем наш разговор об уличной фотографии. Сегодня хотелось бы поговорить о сюжете в стрит фотографии. Вы скажите, что это странная тема для разговора – ну какой может быть сюжет у уличного фото. Кстати, то что в уличной фотографии отсутствует сюжет, очень распространенное мнение.

Обычно сторонники того, что уличная фотография может не иметь сюжета, говорят, что уличная фотография — это просто фиксация не событий, а обычной жизни города вообще. А какой сюжет может быть в обычной жизни? Люди просто идут или стоят.

На остановкеНа остановкеСмысл в таких рассуждениях есть. Если вы вышли из дома и, идя по улице, делаете снимки раз в 10 минут (можно и чаще), то сюжет в этой серии снимков будет очевиден только для вас – маршрут моей прогулки. И если вы опубликуете один из таких снимков без названия, без описания и пояснений, то стороннему зрителю может показаться, что сюжет в этой фотографии отсутствует. Особенно если на ней нет ничего такого, чтобы притягивало взгляд. Но, тем не менее, даже у такой фотографии сюжет имеется. Во всяком случае, для ее автора.

У этой фотографии может быть несколько сюжетных линий: Лето; Девушки Саратова, Проспект Кирова в Саратове летомСитуация, описанная мной, встречается сплошь и рядом. Загляните на фото сайты и вы увидите сотни фотографий, которые выкладываются ежеминутно, снятых непонятно где и непонятно о чем. Эта безликая масса изображений не вызывает никаких эмоций – просто какие-то картинки. Люди просто фотографируют все подряд – что вижу, то и снимаю. Иногда получаются отличные кадры, но большинство снимков не интересны даже их автору.

Эта безликая масса изображений не вызывает никаких эмоций – просто какие-то картинки. Люди просто фотографируют все подряд – что вижу, то и снимаю. Иногда получаются отличные кадры, но большинство снимков не интересны даже их автору.

Это плохо – спросите вы. Нет, это нормально, особенно для начинающего уличного фотографа. Иногда уличного фотографа можно сравнить с золотоискателем, старателем времен Золотой лихорадки. Сотни тонн породы промыто, а на выходе всего пара грамм драгоценного металла. Ну да, как-то так получается, если не предпринять никаких мер по повышению эффективности съемки. А давайте подумаем вот над чем – для чего мы снимаем и вообще занимаемся уличной фотографией? Ради чего – для признания, лайков или просто мы таким образом снимаем стресс?

Что я там наснимал?Цель уличной фотографии

В чем цель уличной фотографии и есть ли в ней смысл? Уличный фотограф – для чего он снимает, зачем часами бродит по улицам? У вас есть ответы? А у меня, есть что ответить. Еще несколько лет назад я для себя ответил на эти вопросы.

Еще несколько лет назад я для себя ответил на эти вопросы.

Главная цель уличной фотографии, на мой взгляд – это летопись жизни в фотографиях. Ну да, звучит довольно пафосно, но это именно так. Уличный фотограф годами снимает улицы и людей. За 10 – 50 лет (кому как повезет) накапливается целый архив. И если разглядывать эти снимки, то можно увидеть, как менялся город и люди, в нем живущие. Это очень увлекательно. Вы помните историю Вивьен Майер и обнаруженных совершенно случайно ее фотографий? Они потрясли Америку. Это была хроника американской жизни почти за 50 лет. Просто потрясающая летопись американской жизни. Найдите время и посмотрите эти снимки — vivianmaier.com. Женщина годами фотографировала и бережно сохраняла снимки. О ней никто не знал, пока, к сожалению, уже после ее смерти, негативы и отпечатки не были куплены на распродаже.

Совет: Начиная заниматься уличной фотографией, позаботьтесь о том, чтобы каталогизировать свои снимки. Из собственного опыта – до сих пор жалею, что удалил снимки за несколько лет, когда поменял компьютер.

Осталось что-то в аккаунтах социальных сетей, но многое пропало – жаль. Поэтому, советую сохранять снимки. Возможно, не все, но фиксируйте дату и храните хотя бы часть из каждой серии. Стоит озаботиться покупкой дополнительных жестких дисков или сохраняйте на виртуальных дисках в Google, Yandex или на других сервисах.

Мы определилась с основной целью фотографией. Теперь перейдем к целям поменьше и к сюжету.

Сюжет или тема в стрит фотографии

Выходя на прогулку с фотоаппаратом, стоит подумать о том, что я сегодня буду снимать. Улицы, людей, голубей, котиков? Да, это мы обычно и снимаем. Но можно и немного уточнить. Например, сегодня я буду снимать туристов, а завтра сниму ребят на роликах и скейтах, а может сконцентрирую свое внимание на пенсионерах или молодых родителях. Мы выбираем сюжет съемки.

Туристы в МосквеТуристы в МосквеПочему это лучше, чем простая съёмка всего подряд? Я сейчас выскажу собственное мнение по этому поводу, а вы уж сами судите –так это или нет.

На мой взгляд, если мы выбираем более узкое направление съемки, то становимся внимательней и замечаем то, что при простой прогулке пропустили бы и не заметили. Больше уделяем внимание деталям. От этого выигрывают и наши снимки.

По сути, выбирая тему для снимков, мы уже не просто ходим по улицам с камерой, а делаем репортаж. Надо сказать, что репортажная съемка пересекается с уличной фотографией в 90% случаев.

Праздник еды в саду Эрмитаж или просто Перкус в паркеЧто такое репортаж? Это серия снимков с какого-то события или серия снимков о чем-то – о городе, об улице, о людях. Ведь репортаж – это необязательно известные личности или светский раут.

Репортаж – это серия снимков. Если мы возьмем и опубликуем только одну фотографию из репортажа, то такой снимок будет именно уличным, если репортаж сделан на улицах города.

Еще раз, выбирая сюжет фотографий для съемки, мы делаем репортаж и если выкладывать серию фотографий, то именно так эти снимки и будут восприниматься. Если же выкладывать фотографии по одной, то это будет обычная уличная фотография.

Если же выкладывать фотографии по одной, то это будет обычная уличная фотография.

На самом деле, довольно часто отличия уличной съемки от репортажной заключаются в том, кто делал серию – профессионал или любитель и где снимки были опубликованы.

Хотелось бы обратить ваше внимание еще на одном моменте – название снимка. Мы прогулялись, сделали во время прогулки серию снимков и сбросили все снятое на компьютер. Пока они хранятся у нас и не опубликованы – это просто снимки. Но в тот момент, когда мы их решили опубликовать, возникает проблема – давать им название или нет. Если мы выкладываем снимки на всеобщее обозрение без названий, то можно сказать, что сюжет этих фотографий не очевиден. Как только мы даем название, то у наших фотографий автоматически сюжет появляется. Мы его придумываем или уточняем. Задумайтесь над этим. Может стоит продумать названия заранее. Кто-то скажет, а как же свобода творчества. Ну да, ну да. Тогда задам вам вопрос – как художник рисует свои картины? Фотография – это и есть картина, только сделанная не кистью и красками, а сложной техникой.

Тогда задам вам вопрос – как художник рисует свои картины? Фотография – это и есть картина, только сделанная не кистью и красками, а сложной техникой.

фото сюжетов

фото сюжетовРуководство по установлению точек и фотографированию

для мониторинга проектов управления водосборными бассейнами

158 12-я улица NE

Салем, Орегон

Октябрь 1993 г.

- Фото Участки

- КАКОЕ ОБОРУДОВАНИЕ МНЕ ПОТРЕБУЕТСЯ?

- ОК! СДЕЛАЕМ ФОТОГРАФИИ

- КАКОЕ ОБОРУДОВАНИЕ МНЕ ПОТРЕБУЕТСЯ?

- КРУПНЫМ ПЛАНОМ

- ОБЩИЙ ВИД ФОТОГРАФИИ

- КАК Я МОГУ НАЙТИ ТАКОЙ ЖЕ ФОТОСЮЖЕТ В СЛЕДУЮЩЕМ ГОДУ?

- КАК ДЕЛАТЬ ПОСЛЕДУЮЩИЕ ФОТОГРАФИИ?

- ЧТО ЕСЛИ МНЕ НУЖНА ПОМОЩЬ?

- Таблица 1. Мониторинг общих практик для обеспечения эффективности

- Рис. 1. Постоянная фотография крупным планом Местоположение

- Рис. 2. Идентификационная этикетка с фотографией

- Рис.

3. Общий вид фотоэпюр

3. Общий вид фотоэпюр - КАК ДЕЛАТЬ ПОСЛЕДУЮЩИЕ ФОТОГРАФИИ?

Фото Участки

Простой способ мониторинга проектов управления водоразделом

Мониторинг является эффективным способом выяснить, соответствует ли проект управления водоразделом поставленным целям и задачам. Мониторинг может показать, насколько хорошо или плохо работает система управления. Это может помочь определить необходимые изменения в управлении и может показать другим, как улучшить водоразделы и прибрежные районы.

Многие виды систем мониторинга используются для документирования результатов проектов по улучшению водосборных бассейнов. Некоторые системы, такие как проведение измерений и запись научных данных, могут быть требовательными и довольно сложными. На разработку и анализ данных может уйти много лет.

Другие системы довольно просты. Фотосъемка является одним из основных методов мониторинга. Хотя фотографии не могут рассказать всю историю проекта, много информации можно собрать из фотографий, сделанных в одном и том же месте в течение нескольких лет.

Фотографии часто показывают изменения, которые не замечают измерения. Они служат напоминанием о том, как далеко вы продвинулись в создании здорово функционирующей территории с природными ресурсами. Фотографии — это простой способ рассказать другим о преимуществах надлежащей практики управления земельными ресурсами.

Эта брошюра может помочь вам установить контрольные точки или фотопланы, с которых можно делать снимки для отслеживания изменений, происходящих в результате проекта управления ресурсами.

КАКОЕ ОБОРУДОВАНИЕ МНЕ ПОТРЕБУЕТСЯ?

Вам понадобится всего несколько расходных материалов для фотомониторинга вашего проекта.

Вам понадобится фотоаппарат, конечно, желательно 35 мм, и пленка. Подойдет как печатный, так и слайдовый формат, хотя большинство менеджеров по природным ресурсам предпочитают слайды. Хотя на самом деле это не является жизненной необходимостью, вы также можете захотеть иметь штатив для камеры, чтобы получать устойчивые и четкие снимки.

Для фотографий крупным планом вам понадобятся четыре куска углового железа или арматуры длиной около 16 дюймов (или любой высоты, которую вы можете легко увидеть), а также молоток или отбойный молоток в зависимости от состояния грунта. для фотографий общего вида вам понадобятся две стойки высотой от 3 до 4 футов. Яркая аэрозольная краска для кольев поможет вам найти их позже.

Также необходимы деревянная или стальная измерительная рулетка, фотоидентификационные этикетки, карта соответствующего масштаба, например, квадратный лист Геологической службы США, и черный фломастер.

ОК! СДЕЛАЕМ ФОТОГРАФИИ

В таблице 1 показано, какие фотографии следует делать для мониторинга определенных методов управления. В зависимости от типа вашего проекта есть два типа фотографий, которые вы, возможно, захотите сделать: крупный план и общий вид.

ФОТОГРАФИИ КРУПНЫМ ПЛАНОМ

На фотографиях крупным планом показаны конкретные характеристики территории, такие как поверхность почвы или площадь поверхности земли, покрытая растительностью и органическим мусором. Периодически делаются снимки крупным планом с постоянно расположенных фототочек.

Периодически делаются снимки крупным планом с постоянно расположенных фототочек.

Обычно площадь 3 фута x 3 фута используется для фотосъемки крупным планом. Чтобы отметить углы квадрата, вбейте в землю уголки из железа или арматуры во всех четырех углах (рис. 1). Покрасьте колышки ярким цветом, например, желтым или оранжевым, чтобы вам было легче перемещать их во время последующей фотосъемки. Возможно, вам придется перекрашивать их время от времени, если они выцветают.

Если у вас есть камера со сменными объективами, вы должны планировать использовать тот же объектив на вашей камере во время последующей фотосъемки, что и при установке исходной точки съемки и при съемке первых снимков.

Вы и ваша камера должны стоять на северной стороне участка. Стоя с северной стороны, можно делать фотографии в любое время дня, не отбрасывая тень на участок.

Перед фотографированием положите заполненную идентификационную этикетку с фотографией (см. рис. 2) на землю рядом с фотоплощадкой.![]()

Поместите стальную или деревянную измерительную ленту поперек южной стороны участка. Лента должна быть открыта на 36 дюймов, при этом лента должна читаться слева направо.

Лента придаст фотографии некоторый относительный масштаб. Встаньте примерно в шести-восьми футах от центра участка. Убедитесь, что вы видите метку в видоискателе камеры.

Сделав снимок, отметьте на карте расположение фотоучастка вместе со стрелкой, указывающей направление, в котором вы сделали снимок.

Если вы отправляете фотографии наблюдения кому-то еще, например, в качестве приложения к отчету, обязательно сохраните копию фотографий и карту для себя. Копии помогут вам найти то же самое место и выровнять ориентиры для последующих фотографий. Они также помогут вам увидеть изменения, которые произошли с тех пор, как были сделаны последние снимки.

ФОТОГРАФИИ ОБЩЕГО ВИДА

Фотографии общего вида можно разделить на две категории: особенности и пейзажи.

Художественные фотографии документируют изменения на крупных объектах или вокруг них, таких как каменные дамбы, берега ручьев или профили ручьев. Снимки могут быть сделаны с видами поперек, вверх по течению и / или вниз по течению (показывая, например, изменения в профиле реки), или поперек или вверх и вниз по линии забора, чтобы показать контраст между различными действиями по управлению земельными ресурсами.

Снимки могут быть сделаны с видами поперек, вверх по течению и / или вниз по течению (показывая, например, изменения в профиле реки), или поперек или вверх и вниз по линии забора, чтобы показать контраст между различными действиями по управлению земельными ресурсами.

Художественные фотографии обычно делаются с противоположных концов воображаемой линии. Например, вы можете настроить фотографик для наблюдения за изменениями на противоположных сторонах ручья. Для этого по обеим сторонам ручья вбейте в землю кол или столб. Две точки должны находиться на расстоянии 30 или 40 футов друг от друга. Поместите идентификационную этикетку с фотографией в вертикальное положение так, чтобы она находилась на переднем плане фотографии. Удерживая камеру над одним стержнем, отцентрируйте другой стержень посередине фотографии. Для следующей фотографии повторите процедуру в обратном порядке. Не забудьте включить метку фотографии и, если возможно, немного неба на фотографии, чтобы помочь установить масштаб фотографируемых объектов.

Пейзажные фотографии представляют собой обзор области, показывающий объект и его связь с окружающей территорией. Пейзажная фотография может быть сделана с близлежащего холма, показывая издалека тот же участок ручья, где была сделана тематическая фотография.

На рис. 3 приведены некоторые примеры фотографиков общего вида.

КАК Я МОГУ НАЙТИ ТАКОЙ ЖЕ ФОТОСЮЖЕТ В СЛЕДУЮЩЕМ ГОДУ?

Оставив ярко окрашенные колышки на месте, вы отметите точное местонахождение участка фото. Однако из-за роста растительности и других изменений фотоучасток может быть плохо виден в последующие годы. Фотография местности вокруг участка, сделанная с ближайшей дороги в момент закладки участка, может облегчить определение общего местоположения.

Опять же, не забудьте сохранить копии всех фотографий для себя!

КАК ДЕЛАТЬ ПОСЛЕДУЮЩИЕ ФОТОГРАФИИ?

Когда вы делаете последующие фотографии, следуйте тому же процессу, что и при съемке первоначальных. Включите те же ставки и новую метку на фотографии крупным планом. Совместите те же ориентиры и вехи на последующих фотографиях общего вида. Не забудьте сделать новую этикетку.

Включите те же ставки и новую метку на фотографии крупным планом. Совместите те же ориентиры и вехи на последующих фотографиях общего вида. Не забудьте сделать новую этикетку.

Чтобы придать достоверность вашим фотографиям и действительно показать результаты, лучше всего делать последующие фотографии примерно в то же время года, что и оригиналы.

ЧТО ЕСЛИ МНЕ НУЖНА ПОМОЩЬ?

Если вам нужна дополнительная информация о том, как настроить фотопечать или сделать последующие фотографии, свяжитесь с GWEB по телефону 503-378-3589. Мы направим ваш запрос соответствующему лицу в вашем районе.

Таблица 1

| Упражняться | Улучшает водоразделы (качество и количество воды) за счет … | Отслеживайте, делая (до, во время, после) фотографии … |

|---|---|---|

| Контрольный можжевельник на возвышенностях | .  .. уменьшая транспирацию, позволяя травам расти, чтобы они могли препятствовать и фильтровать поверхностный сток, а также увеличивать плотность корней, чтобы удерживать почву .. уменьшая транспирацию, позволяя травам расти, чтобы они могли препятствовать и фильтровать поверхностный сток, а также увеличивать плотность корней, чтобы удерживать почву | … места, где можжевельник был убит или удален |

| Управление выпасом домашнего скота с помощью новых схем севооборота, ограждений или гидротехнических сооружений | … увеличение травяного покрова и рост травы на возвышенностях для перехвата осадков, препятствия и фильтрации сухопутного стока, а также уменьшения эрозии и заиления. Уменьшение уплотнения в прибрежных районах, чтобы уменьшить обрушения берегов, эрозию и заиливание ручьев | … репрезентативные районы на возвышенностях и береговые профили в прибрежных районах |

| Установите стабилизирующую градиент каплевидную конструкцию , чтобы частично перекрыть поток и сформировать бассейн. | … снижение скорости потока, улавливание наносов, уменьшение эрозии берегов ручья и прорезания русел, а также содействие восстановлению растительности на берегах рек | .  .. профили репрезентативных берегов. Измерьте глубину ила за конструкциями .. профили репрезентативных берегов. Измерьте глубину ила за конструкциями |

| Строительные причалы в руслах рек для частичного перекрытия речного стока и формирования лужи | … снижение скорости течения, позволяющее оседать наносам и защищающее русло ниже по течению от прорези, обрушения берегов и эрозии | … вниз по течению от причалов с расстояния около 30 футов |

| Травянистые насаждения на возвышенностях | … увеличение травяного покрова, чтобы перехватывать осадки, препятствовать стоку, уменьшать эрозию, увеличивать инфильтрацию и фильтровать поверхностный сток | … репрезентативные пейзажи |

| Посадка растительности на тугайных участках | … закрепление прибрежной почвы, уменьшение обрушения берегов ручья, эрозии и прорезания русел; содействие восстановлению растительности на берегах рек и восстановление профиля русла; улавливание мусора, фильтрация ручья, обеспечение тени и снижение температуры ручья | .  .. репрезентативные профили берегов ручья (с горизонтом на верхнем краю фотографии) .. репрезентативные профили берегов ручья (с горизонтом на верхнем краю фотографии) |

| Установите каменную наброску из спиленных деревьев , чтобы берега ручья | … препятствующие течению и скорости потока вдоль берегов; уменьшение эрозии, прорезания каналов и обрушения берегов; уменьшение заиления, содействие восстановлению растительности на берегах рек для дальнейшего улавливания отложений; уменьшение уплотнения и вытаптывания скотом в прибрежных районах | … сечения берегах ручьев, уделяя особое внимание местам типичных установок |

| Установить устройства управления рубкой | … прекращение прорезания русла, содействие заживлению русла, помощь в восстановлении профиля русла и содействие накоплению воды в прибрежных районах | … зоны обработки, обеспечивающие косой обзор проблемных участков |

Рисунок 1

| |

- Покрасьте столбы яркой перманентной аэрозольной краской (желтой или оранжевой), чтобы облегчить перемещение. Перекрасьте эти ставки, когда будут сделаны последующие фотографии.

Рисунок 2

| |

- Создайте этикетку с этой информацией. Этикетка должна быть достаточно крупной, чтобы ее можно было прочитать на фотографии.

Рисунок 3

| |

Для просмотра и печати документов, представленных в виде файлов PDF, требуется Adobe(R) Acrobat(R) Reader (бесплатно).

Четверг, 06 августа 1998 г. , 20:32:25 PDT , 20:32:25 PDT |

One Hour Photo (2002) – Краткое изложение сюжета

ПравитьФото за час (2002)

Прыгать на:

- Резюме (4)

- Резюме (1)

Резюме

Психически неуравновешенный фотопроявитель нацелился на семью из высшего среднего класса после того, как его одержимость ими стала более болезненной и тревожной, чем кто-либо из них мог себе представить.

Сай Пэрриш средних лет работает техником в часовой фотолаборатории, расположенной в магазине SavMart в пригородном торговом центре. Сай — одинокий человек, у него никогда не было друзей. Он многое знает о своих клиентах благодаря фотографиям, которые они разработали. Но он знает о семье Йоркин больше, чем кто-либо другой, особенно о Нине Йоркин и ее сыне-подростке Джейке Йоркине, о двух членах семьи, которые привозят и забирают семейные фотообработки, о семье, которой он одержим.

Муж Нины, Уилл Йоркин, не связан с его одержимостью, поскольку Сай видела его только на фотографиях. Одержимость Сая включает в себя фантазии о том, чтобы стать их любимым «дядей Саем». Он даже делал для себя дополнительный набор отпечатков всех их фотографий с тех пор, как Джейк был новорожденным. После инцидента на работе и после того, как Сай узнает больше о семье с помощью набора фотографий, он решает исправить несправедливость, которую он видит, единственным известным ему способом. Его действия демонстрируют его истинное психическое состояние.

Муж Нины, Уилл Йоркин, не связан с его одержимостью, поскольку Сай видела его только на фотографиях. Одержимость Сая включает в себя фантазии о том, чтобы стать их любимым «дядей Саем». Он даже делал для себя дополнительный набор отпечатков всех их фотографий с тех пор, как Джейк был новорожденным. После инцидента на работе и после того, как Сай узнает больше о семье с помощью набора фотографий, он решает исправить несправедливость, которую он видит, единственным известным ему способом. Его действия демонстрируют его истинное психическое состояние.—Хьюго

Сеймур ‘SY’ Пэрриш занимается фотопроявкой уже 20 лет. Он обладает обширными знаниями в области современной фотографии и зарабатывает на жизнь проявкой фотографий в местном универмаге. Но SY живет грустной и одинокой жизнью и начинает шпионить за семьей Йоркиных, его самыми большими клиентами, у которых, кажется, есть все на свете.

SY начинает чувствовать, что хочет быть в жизни йоркинов, но когда он обнаруживает, что йоркины не так совершенны, как кажутся, он становится человеком, выполняющим миссию по разоблачению несовершенства семьи йоркинов, которые могут разлучить их.

SY начинает чувствовать, что хочет быть в жизни йоркинов, но когда он обнаруживает, что йоркины не так совершенны, как кажутся, он становится человеком, выполняющим миссию по разоблачению несовершенства семьи йоркинов, которые могут разлучить их.— Джеффри А. Миддлтон

Фото-клерк универмага, Сеймур «Сай» Пэрриш, исключительно хорошо разбирается в фотографии и занимается проявкой фотографий для семьи Йоркин с тех пор, как их сын был младенцем. Тем не менее, Сай также живет очень одинокой и одинокой жизнью — без жены, подруги или семьи на картинке. У Сая начинает развиваться тревожная одержимость Йоркинами и тем, что у них есть, и когда его увольняют за кражу, он перебарщивает. Раскрыв тревожную тайну о мистере Йоркине, он леденящим душу гневом мстит…

— Дерек О’Кейн

Спойлеры

Синопсис ниже может выдать важные моменты сюжета.

Сводка

- Сеймур «Сай» Пэрриш (Робин Уильямс), фототехник в мини-лаборатории одночасовой фотопроявочной клиники SavMart в пригороде Лос-Анджелеса, ведет депрессивную уединенную жизнь за пределами «небесной» гиперреалистичной атмосферы универмаг. Каждый день он трудится над тем, чтобы его клиенты получали фотографии самого высокого качества; его жизнь — это действительно его работа, так как ему не к кому и не к чему вернуться домой в конце каждого дня. Каждый рабочий день подходит к концу, и Сай погружается в неотвратимую рутину, проводя вечера в одиночестве в своей пустынной гостиной перед телевизором. Единственное, что есть у Сая в безупречной квартире, это хомяк, запертый в его спальне. Он чрезвычайно организованный, аккуратный и дотошный человек, который носит всю бежевую одежду. Чувствуя себя неуместным в мире, где, кажется, никто не понимает драгоценного дара друзей и семьи, Сай стремится погрузиться в свои собственные фантазии, чтобы избежать боли своего существования.

Его любимые клиенты — семья Йоркинов, состоящая из мужа Уилла (Майкл Вартан), жены Нины (Конни Нильсен) и их сына Джейка (Дилан Смит). Он много лет делал их фотографии и со временем увлекся семьей; он боготворит их счастье и изобилие, запоминает все личные подробности о них, которые он может узнать, и, наконец, начинает преследовать их. Сай тайно делает свои собственные копии фотографий Йоркиных с негативов, а затем прикрепляет их к стене в своей квартире, создавая массивный коллаж, который насчитывает более 600 штук. Больше всего он мечтает о том, чтобы стать членом их семьи и разделить любовь, которую, по его мнению, они должны испытывать. Однако он болезненно застенчив, и его неуклюжие попытки сблизиться с семьей мягко отвергаются.

Сю в конце концов удается установить связь с Ниной, когда он притворяется, что интересуется романом, который, как он заметил, она читала в определенный день в магазине. Впервые Нина задает Сая личные вопросы о его жизни, понимая, что он действительно одинокий человек, на что раньше с сочувствием обращал внимание только Джейк.

Однако эта связь недолговечна, поскольку босс Сая, мистер Оуэнс, на следующий день увольняет его за кражу отпечатков. Просматривая свои фотографии в последний раз, Сай обнаруживает, что у Уилла роман, и его идиллическое представление о Йоркинах как об «идеальной» семье рушится. Он начинает ненавидеть и завидовать Уиллу, у которого есть все, о чем мечтает Сай, но, похоже, ему все равно.

Однако эта связь недолговечна, поскольку босс Сая, мистер Оуэнс, на следующий день увольняет его за кражу отпечатков. Просматривая свои фотографии в последний раз, Сай обнаруживает, что у Уилла роман, и его идиллическое представление о Йоркинах как об «идеальной» семье рушится. Он начинает ненавидеть и завидовать Уиллу, у которого есть все, о чем мечтает Сай, но, похоже, ему все равно.Потеряв работу, Сай выслеживает и фотографирует маленькую дочь Оуэнса, что приводит к полицейскому расследованию против него. Пока детективы Ван Дер Зи и Аутербридж (Эрик Ла Саль и Кларк Грегг) обнаруживают одержимость Сая, Сай противостоит Уиллу и его любовнице Майе (Эрин Дэниэлс) во время свидания в их гостиничном номере. С помощью ножа и фотоаппарата Сай заставляет влюбленных позировать обнаженными, пока он фотографирует. На протяжении всего испытания Майя паникует, а Сай агрессивно реагирует, но не причиняет вреда ни одному из них. После противостояния, когда Сай просто сидит на кровати в своем гостиничном номере, он обнаруживает, что в отель прибыла полиция, и пытается сбежать.

Звучит сигнал тревоги, и Ван Дер Зи преследует его, в то время как Аутербридж обнаруживает Уилла Йоркина и его любовницу, невредимых, но травмированных. После погони полиция наконец задерживает Сая в гараже, когда он пытается убежать от своей машины. При аресте. Сай утверждает: «Я просто фотографировал».

Звучит сигнал тревоги, и Ван Дер Зи преследует его, в то время как Аутербридж обнаруживает Уилла Йоркина и его любовницу, невредимых, но травмированных. После погони полиция наконец задерживает Сая в гараже, когда он пытается убежать от своей машины. При аресте. Сай утверждает: «Я просто фотографировал».Финальная сцена происходит в комнате для допросов в полиции, где Ван Дер Зи спрашивает Сая, почему он терроризировал Йорков, на что Сай косвенно сообщает, что его отец заставлял его делать «больные, отвратительные вещи, которые ни один ребенок никогда не должен делать». . Подтекст, подтвержденный Романеком, состоит в том, что отец Сая эксплуатировал его для детской порнографии. Романек также подтвердил, что Сай использовал камеру как средство наказания Уилла и противостояния его прошлому, поскольку его отец говорил ему, что «это все просто притворство», оскорбляя его. Сай не может понять, почему Уилл, будучи идеальным отцом, был полон решимости разрушить свою семью и, таким образом, навсегда покончил с фантазией, которой он придерживался почти 10 лет.

Когда детектив начинает понимать его и готовится принять его признание, Сай просит фотографии, которые он сделал в отеле, которые детектив назвал «доказательством». Судя по всему, это всего лишь снимки предметов домашнего обихода и предметов интерьера, которые он сделал после инцидента в отеле. Это означает, что Сай никогда не фотографировала Уилла и Майю, а только делала вид. Однако в более ранней режиссерской версии мы видим дополнительные удаленные сцены, в которых полиция анализирует настоящие фотографии Уилла и Майи с места преступления, сделанные Сай.

Фильм завершается фотографией семьи Йоркин с Си. Романек утверждает в комментарии к DVD, что изображение призвано символизировать открытый финал; Зрителю остается решить, существует ли картина только в сознании Сая или он когда-нибудь снова увидит семью Йоркиных.

См. также

Слоганы | Синопсис | Ключевые слова сюжета | Руководство для родителей

Начало работы | Зона авторов »

Внести вклад в эту страницу

исследовать закономерности в больших коллекциях изображений

Что такое ImagePlot?

Исследуйте изображения и видео по-новому.

Как это работает?

Создавайте визуализацию и анимацию в высоком разрешении и настраивайте все под себя.

Будет ли он работать с моими вещами?

Работает с любыми носителями, на любой платформе (почти).

Что такое ImagePlot?

ImagePlot — это бесплатный программный инструмент, который визуализирует коллекции изображений и видео любого размера. Он реализован в виде макроса, который работает с программой обработки изображений с открытым исходным кодом ImageJ.

ImagePlot был разработан Инициативой по изучению программного обеспечения при поддержке Национального фонда гуманитарных наук (NEH), Калифорнийского института телекоммуникаций и информационных технологий (Calit2) и Центра исследований в области вычислительной техники и искусства (CRCA).

Просматривайте всю свою коллекцию изображений в одной визуализации.

Существующие средства визуализации отображают данные в виде точек, линий и полос. Визуализации ImagePlot показывают фактические изображения в вашей коллекции. Изображения можно масштабировать до любого размера и упорядочивать в любом порядке — в соответствии с их датой, содержанием, визуальными характеристиками и т. д. Поскольку цифровое видео — это всего лишь набор отдельных неподвижных изображений, вы также можете использовать ImagePlot для изучения шаблонов в фильмах, анимации. , видеоигры и любые другие данные движущихся изображений.

Визуализации ImagePlot показывают фактические изображения в вашей коллекции. Изображения можно масштабировать до любого размера и упорядочивать в любом порядке — в соответствии с их датой, содержанием, визуальными характеристиками и т. д. Поскольку цифровое видео — это всего лишь набор отдельных неподвижных изображений, вы также можете использовать ImagePlot для изучения шаблонов в фильмах, анимации. , видеоигры и любые другие данные движущихся изображений.

Лучше разбираться в медиа-коллекциях и делать новые открытия.

Визуализируйте коллекции изображений в виде временных шкал и диаграмм рассеивания, которые отображают все изображения в коллекции. Найдите изображения, которые являются выбросами. Откройте для себя кластеры — наборы изображений, схожих по содержанию или визуальным свойствам. Визуализируйте несколько наборов изображений, чтобы лучше понять их сходства и различия. Изучите закономерности в существующих метаданных (т. е. даты, имена и т. д.), добавленные аннотации и ключевые слова или визуальные характеристики (т. е. яркость, насыщенность, оттенок, формы и т. д.)

е. яркость, насыщенность, оттенок, формы и т. д.)

Визуализируйте изменения.

Мы включили макросы, которые автоматически измеряют различные визуальные свойства каждого изображения в коллекции (или каждого кадра в видео). Эти измерения могут быть визуализированы в виде линейных графиков, диаграмм рассеяния и графиков изображений. Это позволяет увидеть закономерности изменения визуальных характеристик изображений с течением времени. Вы также можете сравнить несколько наборов изображений с точки зрения их визуальных характеристик.

Визуализируйте коллекции изображений любого размера.

От нескольких десятков до миллионов изображений. Теоретически нет ограничений на количество изображений, которые могут быть включены в одну визуализацию. Несколько десятков изображений можно визуализировать за секунду, несколько тысяч — за несколько минут. Самое большое число, которое мы пробовали до сих пор, составляло миллион изображений (да, это заняло некоторое время, но это сработало!). Если ваша коллекция действительно большая, запустите визуализацию и просто вернитесь, когда она будет закончена.

Если ваша коллекция действительно большая, запустите визуализацию и просто вернитесь, когда она будет закончена.

Как это работает?

От точек к изображениям.

Начните с точечных и линейных графиков, которые позволят вам быстро изучить набор изображений. Как только вы найдете интересный шаблон, повторно визуализируйте график, чтобы показать изображения. Перемещайтесь между этими вариантами так часто, как вам нравится.

Рендеринг и сохранение визуализаций в высоком разрешении.

Вы можете визуализировать и сохранять черно-белые и полноцветные визуализации любого размера (при условии, что они не превышают 2,5 ГБ). Например, мы создали визуализацию в оттенках серого 44 000 x 44 000, показывающую один миллион страниц манги, 137 530 x 13 800 визуализация, показывающая все кадры часового фильма, полноцветная визуализация 16 000 x 12 000, показывающая 776 картин Ван Гога. (Все изображения были обработаны на Mac Book Pro с 4 ГБ ОЗУ).

Превратите любую визуализацию в анимацию.

Выберите опцию сохранения визуализации после добавления к ней каждого нового изображения. В результате получается последовательность файлов, которую можно легко превратить в видео (используйте QuickTime или любое приложение для редактирования видео).

Все настроить.

Настройте внешний вид точек данных и линий, фона, осевых линий, меток данных, меток изображений, размера изображений, прозрачности изображения и почти всего остального, что только можно придумать. Мы написали ImagePlot для поддержки как быстрого просмотра наборов изображений, так и создания визуализаций высокого разрешения для публикаций и выставок. Поэтому мы добавили параметры для управления всеми возможными аспектами внешнего вида визуализации. Визуализации, созданные с помощью ImagePlot, демонстрировались в научных центрах, музеях искусства и дизайна и художественных галереях, включая Музей графического дизайна (Бреда), Биеннале дизайна в Кванджу (Корея) и Музей современного искусства Сан-Диего.

Используйте с инструментами анализа цифровых изображений.

Измеряйте различные визуальные свойства изображений в коллекции (яркость, насыщенность, оттенки, формы) с помощью предоставляемых нами макросов или любых других инструментов обработки цифровых изображений. Изучите закономерности этих свойств во всей коллекции с помощью визуализаций ImagePlot.

Будет ли он работать с моими вещами?

Работа с изображениями во всех популярных форматах.

Цветные изображения или изображения в оттенках серого? JPEG или TIFF? Нет проблем, ImagePlot справится со всеми ними. Если изображения имеют разные размеры, ImagePlot также может автоматически масштабировать их до одинакового размера. Если ваши изображения расположены в нескольких каталогах на вашем компьютере, мы также предусмотрели эту возможность.

Кроссплатформенность.

Запустите ImagePlot в Windows, Mac OS или Unix.

Кодирование не требуется.

ImagePlot имеет графический интерфейс пользователя, поэтому вам не нужно ничего программировать или создавать сценарии.

Использовать данные, созданные в других приложениях.

ImagePlot работает с наиболее распространенными форматами данных: набор файлов изображений и данные об этих изображениях, сохраненные в текстовом файле с разделителями табуляцией (.txt). Это делает ImagePlot совместимым со многими другими приложениями для каталогизации мультимедиа, анализа данных и визуализации информации. Вы можете подготовить и отредактировать данные с помощью любого приложения для работы с электронными таблицами или текстового процессора. Файл данных может содержать любое количество строк и столбцов. (Например, наш файл данных для одного миллиона страниц манги содержал один миллион строк и 60 столбцов.)

Загрузите и запустите ImagePlot за считанные минуты.

ImagePlot — это макрос, который выполняется в кросс-платформенной программе обработки изображений с открытым исходным кодом ImageJ. Вместе эти файлы занимают менее 5 МБ. Полная загрузка объемом ~ 100 МБ поставляется с несколькими большими наборами образцов данных, которые полезны для начала работы, но не требуются для работы программного обеспечения.

Код ImagePlot на GitHub

Просмотрите последние коммиты и журнал изменений на нашей странице GitHub .

Загрузить ImagePlot 1.1

Аппаратные требования: 2 ГБ ОЗУ (рекомендуется 4 ГБ или более для визуализации изображений с высоким разрешением).

Требования к программному обеспечению: Чтобы использовать макрос ImagePlot, сначала необходимо установить приложение ImageJ. ImageJ будет работать на Mac, Windows или Linux. Файлы приложений для всех трех операционных систем включены в загружаемый файл ImagePlot.zip.

ImagePlot_v1.1.zip 110 МБ

Макрос ImagePlot, приложение ImageJ (Windows/Mac/Linux), примеры наборов данных, статьи по теории и методологии.

ImagePlot_v1.1-program-only.zip 3 МБ

Макрос ImagePlot, приложение ImageJ (Windows/Mac/Linux).

Предыдущая версия

ImagePlot_v0.9.zip 110 MB

ImagePlot_v0. 9-Program-Only.zip 3 MB

9-Program-Only.zip 3 MB

Что нового в версии 1.1

9003

. Что нового в версии 1.1

. имя файла. Он включает в себя имена файлов данных и столбцы данных, используемые для осей x и y.

Возможность автоматического сохранения визуализации после ее визуализации (появляется в первом диалоговом окне приложения).

Параметр для визуализации визуализации с использованием лучшего алгоритма изменения размера (работает медленнее, но создает более качественные изображения; этот параметр отображается в диалоговом окне «Параметры изображения»).

Проверка ошибки открытия файла: если ImagePlot не может найти определенное изображение, имя файла печатается в окне журнала, но рендеринг продолжается.

Как разработать CNN с нуля для CIFAR-10 Photo Classification

Джейсон Браунли on 13 мая 2019 г. в Deep Learning for Computer Vision

Последнее обновление: 28 августа 2020 г.

Узнайте, как с нуля разработать модель глубокой сверточной нейронной сети для набора данных классификации объектов CIFAR-10.

Задача классификации небольших фотографий CIFAR-10 представляет собой стандартный набор данных, используемый в компьютерном зрении и глубоком обучении.

Несмотря на то, что набор данных эффективно решен, его можно использовать в качестве основы для обучения и практики разработки, оценки и использования сверточных нейронных сетей глубокого обучения для классификации изображений с нуля.

Это включает в себя, как разработать надежный тестовый набор для оценки производительности модели, как изучить улучшения модели и как сохранить модель, а затем загрузить ее, чтобы делать прогнозы на основе новых данных.

В этом руководстве вы узнаете, как с нуля разработать модель сверточной нейронной сети для классификации фотографий объектов.

После завершения этого урока вы будете знать:

- Как разработать набор тестов для надежной оценки модели и установить базовый уровень производительности для задачи классификации.